Warum plötzlich alles anders ist: Die Digitalisierung führt zu einer Phase rapider Innovationen und Marktumwälzungen. In unserer Essay-Reihe blickt Philipp Bouteiller auf die dahinter liegenden Trends und Technologien und beleuchtet, was diese für die Menschen bedeuten. Im ersten Akt dreht sich alles um die Ursprünge der Digitalisierung und die Evolution von Mikrochips.

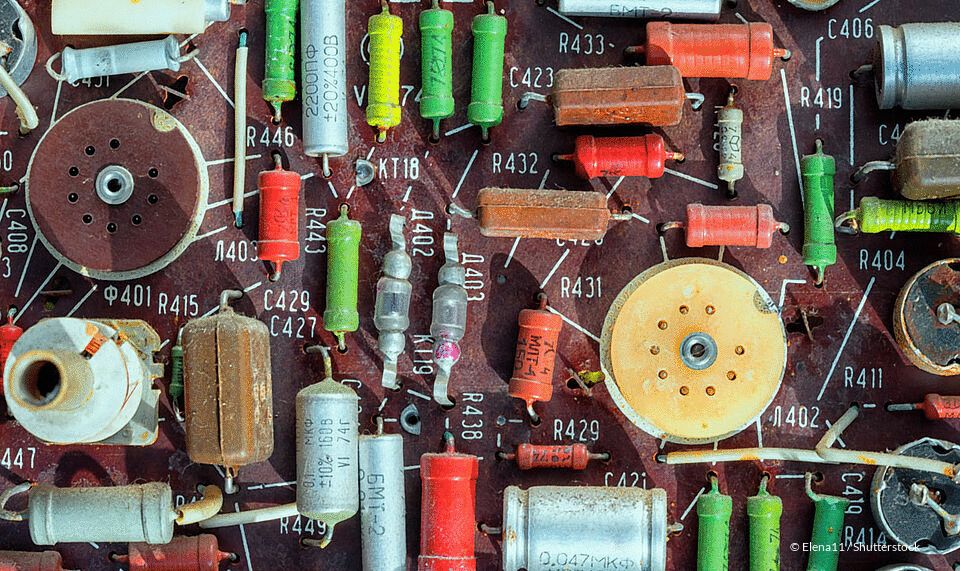

Anfang des letzten Jahrhunderts waren „Computer“ noch Mitarbeiter mit ausgeprägten numerischen Fähigkeiten, die überwiegend in den Buchhaltungsabteilungen großer Firmen tätig waren und dort z.B. lange Zahlenreihen addierten (to compute = be- oder ausrechnen). Dann gab es die ersten Rechenmaschinen. 1941 erfand Konrad Zuse in Berlin den Z3, den ersten „frei programmierbaren Rechner in binärer Schalttechnik und Gleitpunktrechnung“, fast zur gleichen Zeit wurden die ersten modernen Transistoren entwickelt – und der Rest ist Geschichte.

„Moore’s Law“, benannt nach Gordon Moore, einem der Mitgründer von Intel, besagt, dass sich die Rechenleistung von Computerchips (genauer: die Anzahl oder Dichte von Transistoren pro Fläche auf einem integrierten Schaltkreis) etwa alle zwei Jahre verdoppelt. Das iPhone X besitzt inzwischen die über 4000-fache Rechenleistung des legendären Hochleistungsrechners „Cray-1“, der Ende der 1970er-Jahre für etwa 9 Mio. $ an Wetterdienste und Forschungseinrichtungen verkauft wurde (bei heutiger Kaufkraft wären das sagenhafte 39 Mio. $!). Jedes Smartphone ist also schon jetzt ein leistungsfähiger Supercomputer.

Die Miniaturisierung der Schaltkreise hat zwar inzwischen physikalische Grenzen erreicht, und doch hält die Industrie die damals prognostizierte Steigerungskurve der Leistungsfähigkeit von Prozessoren seit mehr als 60 Jahren im Wesentlichen ein. Jetzt werden nicht nur mehrere Computerkerne auf einem kleinen Chip zusammengefasst, um die Leistung auf kleiner Fläche weiter steigern zu können, sondern man stapelt die zusammengefassten Chips sogar dreidimensional übereinander.

So haben wir inzwischen massive Rechenkapazitäten auf kleinstem Raum erlangt und vormals komplexe und teure Prozesse sind so erschwinglich geworden, dass sich der Einsatz von Rechnern selbst in solchen Bereichen lohnt, in denen es bisher zu teuer und aufwändig war.

Wir sind noch lange nicht am Ende der Entwicklung. Nachdem Google bereits 2015 erste Erfolge mit der Quantentechnologie erzielen konnte, haben mittlerweile weitere Firmen wie IBM und Intel ihre eigenen Quantencomputer gebaut. Manche sagen, jetzt ginge es gerade erst los. Die Konsequenz? Alles, was sich digitalisieren lässt, wird digitalisiert – egal, ob wir das für sinnvoll erachten oder nicht.

Der 2. Akt der Essay-Reihe erscheint in 2 Wochen.